شرکت متا، در حال تلاش برای ارتقا مسئولیتپذیری در زمینه بینایی کامپیوتر است و در حال ترویج فناوری بینایی کامپیوتری مسئول میباشد. آنها از مدل DINOv2، یک ابزار مهم در زمینه بینایی کامپیوتری، برای استفاده تجاری بهره میبرند. این شرکت قبلاً با نام فیسبوک شناخته میشد، اما به معرفی به نام متا پرداخته است.

متا همچنین به منظور تشویق به توسعه سیستمهای مسئولیتپذیرتر، در حال توسعه چشمانداز کاری خود در زمینه محاسبات منبعباز است.

شرکت مادر فیسبوک، که حالا به نام متا شناخته میشود، اعلام کرده است که خانواده مدلهای بینایی کامپیوتری DINOv2 را برای استفاده تجاری در دسترس قرار میدهد.

بروز رسانی ابزار هوش مصنوعی متا

متا تغییراتی در مجوز مدل خود به آپاچی 2.0 اعمال کرده است. این به این معناست که اکنون این مدل میتواند در نرمافزارها یا برنامههای دارای مجوز تجاری استفاده شود و امکان دسترسی به ویژگیهای پیشرفته را فراهم کند. با این حال، لازم به ذکر است که استفاده از علائم تجاری آپاچی در نرمافزارهای دارای مجوز اختصاصی یا اسناد مرتبط ممکن است محدود شده باشد.

DINOv2 یک خانواده از مدلهای پایه است که برای رمزگذاری و تجزیه و تحلیل ویژگیهای بصری به کار میرود. توانایی منحصر به فرد این مدل برای یادگیری از مجموعههای متنوع تصاویر، از جمله تخمین عمق، آن را به یک ابزار همهکاره تبدیل کرده است.

هدف اصلی متا از انتقال به مجوز Apache 2.0 و به اشتراکگذاری مجموعه گستردهتری از مدلهای قابل استفاده، تشویق به خلاقیت و افزایش همکاری بین کارشناسان در زمینه بینایی کامپیوتر است. این اقدام امکان استفاده از DINOv2 را در برنامه های مختلف، از تحقیقات تا کاربردهای عملی، فراهم میکند.

همچنین، متا اعلام کرده است که مجموعهای از مدلهای اضافی مبتنی بر DINOv2 را به اشتراک خواهد گذاشت که برای وظایف مانند درک جزئیات تصویر و تخمین عمق در تصاویر قابل استفاده هستند.

علاوه بر این، نسخه نمایشی DINOv2 نیز بازنگری شده و کاربران میتوانند ویژگیهای جالب آن را مانند تخمین عمق، تقسیمبندی تصویر و تطبیق بخشهای مختلف تصاویر را تست کنند.

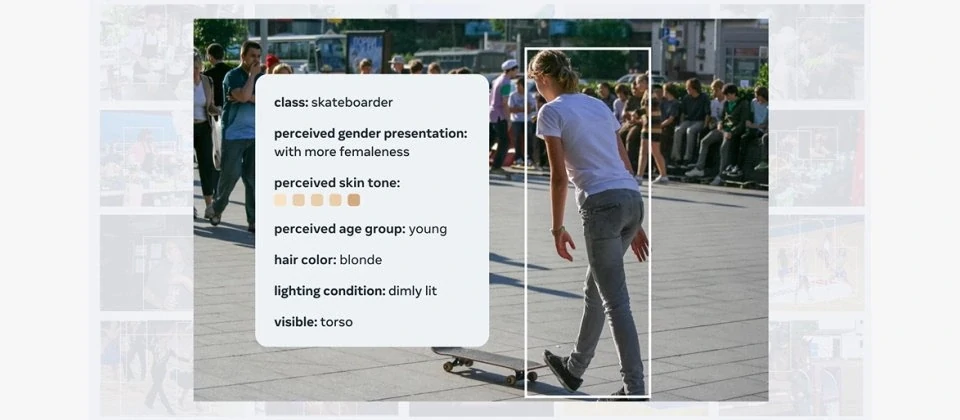

متا همچنین معیار جدیدی به نام FACET را به عنوان ابزاری برای ارزیابی عدالت در مدلهای بینایی کامپیوتری معرفی کرده است.

تیم هوش مصنوعی متا بیان کرده که “عدم سوگیری و تبعیض و ارزیابی عادلانه در حوزه بینایی کامپیوتر همواره یک چالش بزرگ بوده است.”

متا در یک نوشته وبلاگ گفته است: “احتمال وقوع خطا در برچسبگذاری وجود دارد و افرادی که از این سیستمهای هوش مصنوعی استفاده میکنند، تجربههای متفاوتی ممکن است داشته باشند، نه بر اساس پیچیدگی کار اصلی، بلکه بسته به گروهی که در آن فعالیت میکنند.”

FACET صرفاً برای اهداف تحقیقاتی مناسب است و نمیتوان از آن برای آموزش مدلهای هوش مصنوعی بهرهبرداری کرد که شرکتها از آنها به منظور اهداف تجاری خود استفاده میکنند.